🥳JinzAi 上线 !!!👌 Ubuntu 安装ollama

AI-摘要

JinzAI GPT

AI初始化中...

介绍自己

生成本文简介

推荐相关文章

前往主页

前往tianli博客

JinzAi 上线

链接在此:JinzAi

除了在此文章处的链接外,在PC版的页面还在首页顶部菜单和常用页面处有链接。

Ubuntu离线安装ollama

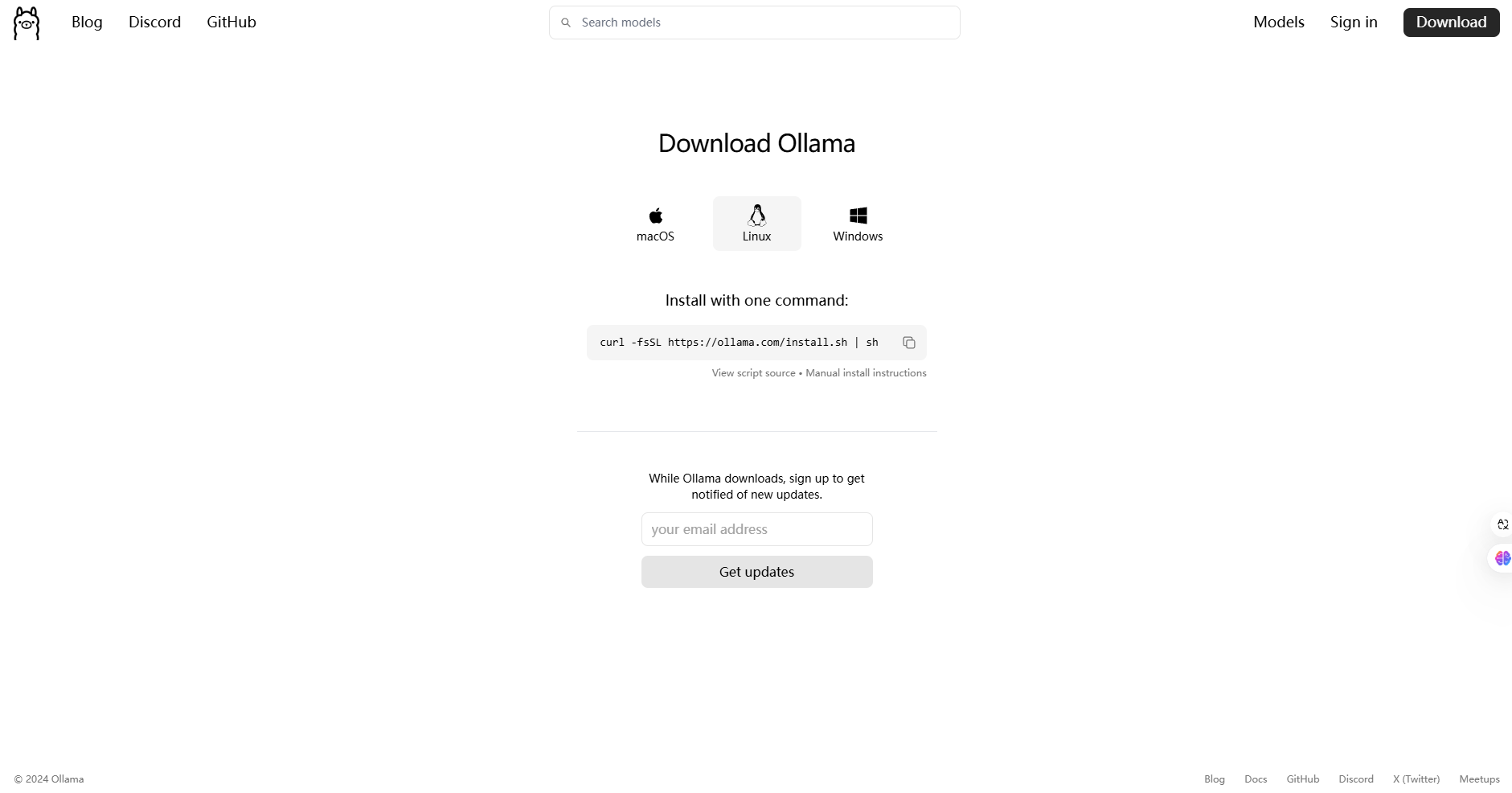

ollama官网 -> 下载 -> Manual install instructions

由于在线下载国内这个网实在是有问题,所以选择离线安装。但是有一说一,点击离线安装指引这个页面打开的是一个GitHub页面,也是时不时的不能访问。

1.下载解压安装包

curl -L https://ollama.com/download/ollama-linux-amd64.tgz -o ollama-linux-amd64.tgz

sudo tar -C /usr -xzf ollama-linux-amd64.tgz2.ollama设置开机启动

2.1.创建ollama用户和组

sudo useradd -r -s /bin/false -U -m -d /usr/share/ollama ollama

sudo usermod -a -G ollama $(whoami)2.2.创建文件

touch /etc/systemd/system/ollama.service文件内容如下:

注意:该文件已修改Environment,为了允许除本机以外的连接

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

[Install]

WantedBy=default.target2.3重启服务

sudo systemctl daemon-reload

sudo systemctl enable ollama3.启动ollama

启动ollama并验证ollama是否在运行。

sudo systemctl start ollama

sudo systemctl status ollama4.模型路径

windows的模型默认路径为:

C:\Users\你的用户名\.ollama\modelsLinux的模型默认路径为:

/usr/share/ollama/.ollama/models/Linux的模型默认路径(ollama serve 测试时)为:

~/.ollama/models/models文件夹包含两个文件夹blobs和manifests,复制模型的时候这两个文件夹里的内容都要复制

o(* ̄︶ ̄*)o(●'◡'●)(づ ̄3 ̄)づ╭❤️~👈(⌒▽⌒)👉👈(⌒▽⌒)👉(👉゚ヮ゚)👉(👉゚ヮ゚)👉

本文是原创文章,采用 CC BY-NC-ND 4.0 协议,完整转载请注明来自 Jinz

评论

匿名评论

隐私政策

你无需删除空行,直接评论以获取最佳展示效果